목표

- 범주형(Categorical) 자료를 다루기 위한 One-hot encoding 기법 이해

- Ridge 회귀를 통한 특성 선택(Feature selection)과정 이해('일반화'의 관점에서)

- 정규화(Regularization)을 위한 Ridge 회귀 모델을 이해

One-hot encoding

이처럼 데이터에 문자열(string)이 존재할 때, 여기서 City 컬럼의 도시 지역을 나타내는 변수는 범주형 변수

범주형 자료는 명목형(nominal; 순서가 없음)과 순서형(ordinal; 순서가 있음)로 나뉘어짐

위의 예시에서 도시는 높고 낮음이 없고 우선순위이 단지 구분만 되기 때문에 명목형

one-hot encoding 모식도

pandas의 get_dummies 이용

df_oh = pd.get_dummies(df, prefix=['City'])

df_oh

여기서 도시가 3가지로 나뉘는데 불필요한 요소를 없앤 방법을 이용(자유도의 개념 : 인천과 서울만 정해져도 두 값이 0인 경우가 부산이 될테니)

df_dum = pd.get_dummies(df, prefix=['City'], drop_first=True)

df_dum

위와 같이 컬럼을 2개만 만들어도 부산 또한 표현할 수 있음

Category_encoders 이용

라이브러리를 사용하면 알아서 범주형 데이터에만 one-hot encoding을 적용

!pip install category_encoders

## import OneHotEncoder

from category_encoders import OneHotEncoder

## 원핫 인코딩

encoder = OneHotEncoder(use_cat_names = True)

X_train = encoder.fit_transform(X_train)

X_test = encoder.transform(X_test) # target인 y에 대해서는 할 필요가 없다!(당연한거)특성 선택(Feature selection)

킹카운티 주택 가격 데이터를 예시로 설명

# import house data

df = pd.read_csv('https://ds-lecture-data.s3.ap-northeast-2.amazonaws.com/kc_house_data/kc_house_data.csv')# np.percentile 사용해 이상치 제거

df = df[(df['price'] >= np.percentile(df['price'], 5)) & (df['price'] <= np.percentile(df['price'], 95))]

# 이렇게 이상치 제거하는 전처리 기억해두기- 특성공학(Feature Engineering)이란 task에 적합한 특성을 만들어내는 과정

- 실무에서 가장 많은 시간이 소요되는 작업 중 하나

- sklearn에서는 모델에 적합한 특성을 골라주는 라이브러리를 제공(SelectKBest)

위의 예시 데이터의 feature 설명 요약

Feature description

- id - Unique ID for each home sold

- date - Date of the home sale

- price - Price of each home sold

- bedrooms - Number of bedrooms

- bathrooms - Number of bathrooms, where .5 accounts for a room with a toilet but no shower

- sqft_living - Square footage of the apartments interior living space

- sqft_lot - Square footage of the land space

- floors - Number of floors

- waterfront - A dummy variable for whether the apartment was overlooking the waterfront or not

- view - An index from 0 to 4 of how good the view of the property was

- condition - An index from 1 to 5 on the condition of the apartment,

- grade - An index from 1 to 13, where 1-3 falls short of building construction and design, 7 has an average level of construction and design, and 11-13 have a high quality level of construction and design.

- sqft_above - The square footage of the interior housing space that is above ground level

- sqft_basement - The square footage of the interior housing space that is below ground level

- yr_built - The year the house was initially built

- yr_renovated - The year of the house’s last renovation

- zipcode - What zipcode area the house is in

- lat - Lattitude

- long - Longitude

- sqft_living15 - The square footage of interior housing living space for the nearest 15 neighbors

- sqft_lot15 - The square footage of the land lots of the nearest 15 neighbors

특성(컬럼)을 고를 수 있는 가지수는 nCk의 sum

즉, 특성을 고르는 방법은 너무 많음

해서 사용할 수 있는 라이브러리가 SelectKBest

# target(Price)와 가장 correlated 된 features 를 k개 고르는 것이 목표입니다.

## f_regresison, SelectKBest

from sklearn.feature_selection import f_regression, SelectKBest

## selctor 정의합니다.

selector = SelectKBest(score_func=f_regression, k=10) # 특성들의 점수는 f_regression을 통해 나오게, k=10으로 10개를 골라달라는 의미)

## 학습데이터에 fit_transform

X_train_selected = selector.fit_transform(X_train, y_train) # train set에 fit하고

## 테스트 데이터는 transform

X_test_selected = selector.transform(X_test) # test data에 대해서는 transform만 하면 된다. 이런 과정을 눈에 익혀두자.선택한 특성 확인

all_names = X_train.columns

## selector.get_support()

selected_mask = selector.get_support()

## 선택된 특성들

selected_names = all_names[selected_mask]

## 선택되지 않은 특성들

unselected_names = all_names[~selected_mask]

print('Selected names: ', selected_names)

print('Unselected names: ', unselected_names)Selected names: Index(['bedrooms', 'bathrooms', 'sqft_living', 'floors', 'view', 'grade', 'sqft_above', 'lat', 'sqft_living15', 'rooms'], dtype='object')

Unselected names: Index(['sqft_lot', 'condition', 'sqft_basement', 'yr_built', 'yr_renovated', 'zipcode', 'long', 'sqft_lot15'], dtype='object')

그렇다면 의문! k를 몇개로 설정하는 게 좋을까??? (이 부분은 참고만 할 것)

# features를 몇 개 선책하는 것이 좋은지 알아 봅시다.

from sklearn.linear_model import LinearRegression

from sklearn.metrics import mean_absolute_error, r2_score

training = []

testing = []

ks = range(1, len(X_train.columns)+1)

# 1 부터 특성 수 만큼 사용한 모델을 만들어서 MAE 값을 비교 합니다.

for k in range(1, len(X_train.columns)+ 1):

print(f'{k} features')

selector = SelectKBest(score_func=f_regression, k=k)

X_train_selected = selector.fit_transform(X_train, y_train)

X_test_selected = selector.transform(X_test)

all_names = X_train.columns

selected_mask = selector.get_support()

selected_names = all_names[selected_mask]

print('Selected names: ', selected_names)

model = LinearRegression()

model.fit(X_train_selected, y_train)

y_pred = model.predict(X_train_selected)

mae = mean_absolute_error(y_train, y_pred)

training.append(mae)

y_pred = model.predict(X_test_selected)

mae = mean_absolute_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

testing.append(mae)

print(f'Test MAE: ${mae:,.0f}')

print(f'Test R2: {r2} \n')

plt.plot(ks, training, label='Training Score', color='b')

plt.plot(ks, testing, label='Testing Score', color='g')

plt.ylabel("MAE ($)")

plt.xlabel("Number of Features")

plt.title('Validation Curve')

plt.legend()

plt.show()위와 같이 for문을 이용해서 MAE값을 낮추고 score가 높아지는 때까지로 반복해볼 수 있다.(어차피 k를 설정하면 알아서 점수 높은 변수부터 골라주니까)

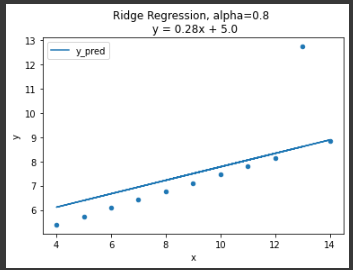

Ridge Regression(능형 회귀) 개념 중요

- Ridge 회귀의 기본은 기존 다중회귀선을 train data에 덜 적합이 되도록 만드는 것.

$$\beta_{ridge} : argmin[\sum_{i=1}^n(y_i - \beta_0 - \beta_1x_{i1}-\dotsc-\beta_px_{ip})^2 + \lambda\sum_{j=1}^p\beta_j^2]$$

n: 샘플수, p: 특성수, $$\lambda$$: 튜닝 파라미터(패널티)

참고: alpha, lambda, regularization parameter, penalty term 모두 같은 의미로 이해

- Ridge 회귀를 사용하는 이유 : 과적합을 줄이기 위해서(모델의 복잡도를 줄이기 위해서; 특성의 갯수를 줄이거나 모델을 단순한 모양으로 적합하는 것)

- 모델학습에 있어 편향(bias)와 분산(variance)의 관점에서 본다면 Ridge 회귀는 편향(bias)을 조금 높이는 대신, 분산(variance)을 줄이는 방법으로 정규화(Regularization)을 수행하게 됩니다. 여기서 정규화란, 모델을 변형하여 과적합을 완화해서 일반화 성능을 높여주는 것을 말합니다.

$$\lambda → 0을 하게 되면, \beta_{ridge} → \beta_{OLS} (즉, 기존 다중선형회귀랑 같음)$$

$$\lambda → ∞을 하게 되면, \beta_{ridge} → 0(학습 자체가 안되니까 회귀계수가 0에 가게 됨)$$

아래와 같은 데이터가 있다.

선형회귀를 진행 했을 때

점점 람다값(알파값)을 증가시키면서 적용

위의 그래프를 통해 alpha=0일 땐 OLS(기존 선형회귀)와 같은 그래프를 그리고, alpha가 커질 수록 직선의 기울기가 0에 수렴하면서 평균 기준모델(baseline)과 같아지는 것을 확인

그렇다면 이 alpha를 최적으로 줄 수 있는 방법은 없을까?

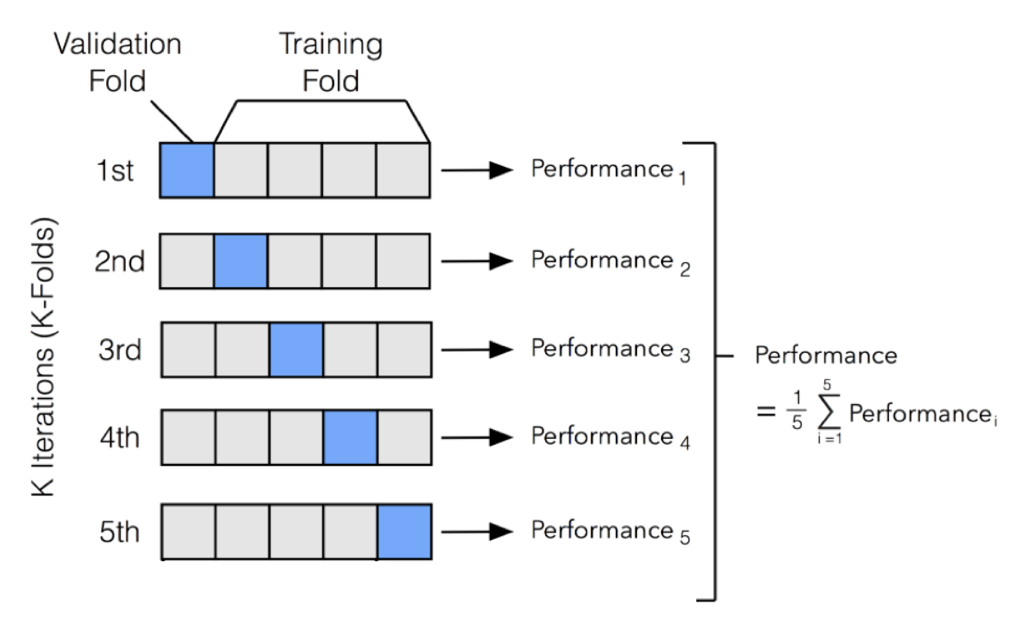

RidgeCV를 통한 최적의 패널티(alpha, lambda) 검증

from sklearn.linear_model import RidgeCV

alphas = [0.01, 0.05, 0.1, 0.2, 1.0, 10.0, 100.0]

ridge = RidgeCV(alphas=alphas, normalize=True, cv=3)

ridge.fit(ans[['x']], ans['y'])

print("alpha: ", ridge.alpha_)

print("best score: ", ridge.best_score_)alpha: 0.2

best score: 0.4389766255562206

즉, alpha가 0.2일 때가 제일 score가 높게끔 해주는 패널티(Ridge regression은 이상치에 그나마 둔감하게 해준다.)

좀더 보너스

RidgeCV에서 CV는 Cross Validation으로 '교차 검증'을 의미한다.

from sklearn.preprocessing import PolynomialFeatures데이터의 각 칼럼에 대해서 다항식형태의 칼럼을 더해준다. 즉, 변수에 대한 다항식으로 모델을 좀더 복잡하게 피팅하고 싶을 때 사용

from sklearn.pipeline import make_pipeline모델을 fit, transform하는 사이킷런의 변환기들을 이어서 한번에 실행할 수 있게 해주는 함수

'💿 Data > 부트캠프' 카테고리의 다른 글

| [TIL]27.Section2_sprint1 challenge (0) | 2021.12.24 |

|---|---|

| [TIL]26.Logistic Regression(로지스틱 회귀; 분류) (0) | 2021.12.22 |

| [TIL]24.다중선형회귀(Multiple Linear Regression) (0) | 2021.12.21 |

| [TIL]23.Simple Regression(단순회귀) (0) | 2021.12.18 |

| [TIL]22.Section Challenge 및 복습 (0) | 2021.12.17 |